教程

精选文章

技术解码:Character.ai 如何实现大模型实时推理性能 2 倍提升

Character.ai与DigitalOcean、AMD深度协同,通过从DP1/TP8/EP8到DP2/TP4/EP4的配置演进及FP8等优化,实现推理吞吐量翻倍,达成千万美元级合作。

全部文章

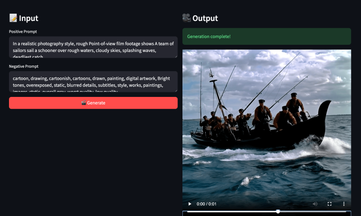

Moltbot/Clawdbot是什么?如何在云服务器部署 Moltbot/Clawdbot?

这是一篇在云服务器上部署和配置AI助手Moltbot/Clawdbot的详细教程。

AI 下半场:Agent 成分水岭,如何选对 GPU 算力攻克推理成本死穴?

AI 竞争重心正从模型规模转向智能体(Agent)。针对 Agent 高频推理、长上下文的特征,算力需求已发生质变。本文拆解了从原型到规模化部署的 GPU 选型逻辑。

如何在Ubuntu系统上配置NFS挂载?(详细步骤指南)

本文提供在Ubuntu系统上配置NFS挂载的完整教程,涵盖主机与客户端的安装、共享目录设置、权限管理及防火墙配置,并对比两种典型场景的权限控制差异。

vLLM 推理 GPU 选型指南:显存、KV Cache 与性能瓶颈全解析

本文系统解析 vLLM 推理运行机制,深入讲清 Prefill 与 Decode 差异、KV Cache 显存增长逻辑及并行开销,结合主流 GPU 架构,对不同模型规模下的显存与性能选型给出清晰参考。

海外云 AWS、GCP、Azure 与 DigitalOcean 的核心区别有哪些?

深度对比 AWS、Azure、GCP 与 DigitalOcean 的性能、带宽成本及 AI 算力差异,为中国出海企业技术负责人提供专业、务实的云服务选型指南。

Agent SKill 教程:编写和部署指南

本文系统介绍了 Agent Skills 的概念与实现方式,讲解其文件结构、集成流程与扩展方法,并结合 DigitalOcean Gradient 无服务器推理,展示模块化 Agent 的构建思路与实践路径。

技术解码:Character.ai 如何实现大模型实时推理性能 2 倍提升

Character.ai与DigitalOcean、AMD深度协同,通过从DP1/TP8/EP8到DP2/TP4/EP4的配置演进及FP8等优化,实现推理吞吐量翻倍,达成千万美元级合作。

2026 年云 GPU 服务商选型全指南:如何为 AI 工作负载选到真正高性价比的算力平台

本文围绕 2026 年云 GPU 市场,结合训练、微调与推理等典型 AI 工作负载,对比主流平台差异,给出兼顾性能、成本与开发体验的选型方法论。

长文档也能稳健推理:QwenLong-L1.5 的记忆增强架构与实战部署指南

QwenLong-L1.5模型,通过后训练与内存框架解决长上下文推理难题,支持超长文档处理,并推荐在DigitalOcean GPU上部署。

Ubuntu/Debian VPS 上 Apache Web 服务器的完整配置教程

本文详细介绍了在 Ubuntu/Debian 系统上配置 Apache 服务器的完整流程,涵盖文件结构解析、全局参数调优、虚拟主机配置及模块管理,并提供性能优化与故障排查实用指南。

想在云上低成本部署高性能Agent?MiniMax-M2 + DigitalOcean实战指南

MiniMax-M2是一款高效开源MoE模型,凭借独特的思维链与工具调用能力,在编码和智能体任务上媲美顶级模型,同时大幅降低部署成本。本文详解其核心优势并提供从云服务选择到API调用的完整部署教程。

从零开始,用 n8n 设计可扩展的自动化工作流

n8n 是一款支持自托管的开源工作流自动化平台,适合开发者与企业构建复杂、低成本的应用集成、AI 与 DevOps 自动化流程。

LLM微调后回答不准还花天价?三步调教出你的“高智商”行业AI模型

将通用大型语言模型通过数据与高效微调技术(如LoRA/QLoRA),转化为高性能、低成本的特定领域专家模型的全流程指南。

Mistral 3 模型解析与部署实战:从 Large 3 到 Mini-stral

本文系统介绍 Mistral 3 开源模型家族,解析 Large 3 与 Mini-stral 的能力差异、硬件需求与适用场景,并演示在 DigitalOcean GPU 上的实际部署流程,帮助开发者低成本落地大模型应用。

H200 在华销售解禁:中国企业想用 H200 服务器,买还是租?

美国允许英伟达向中国出售 H200,企业重新面对“买卡还是上云”的选择。在技术更替加速、成本与不确定性上升的背景下,云端使用 H200 与即将到来的 B300 正在成为更灵活的主流方案。

开源视频生成新标杆:美团LongCat Video全面解析与实战指南

美团LongCat Video是功能强大的开源视频生成模型,支持文本、图像到视频及视频延续,可在配备GPU的服务器上部署运行。