随着人工智能领域的增长,开发越来越强大的GPU的努力依然在持续,以满足用户在云端的需求。每天都有越来越多的相关研究项目发布。此外,硬件需要为新技术的进步而不断优化。

NVIDIA Hopper的发布是其GPU产品中次新的微架构,旨在解决规模扩展的问题。通过Transformer引擎等新技术、分布式设置的互连改进以及高级机密计算,Hopper通过NVIDIA H100的发布,将云端的人工智能开发向前推进了一步。

接下来是NVIDIA H200,在2025年初DigitalOcean的GPU Droplets上已经开始提供H200 GPU服务器。在本文中,我们将深入探讨NVIDIA H200的强大功能,并考虑应在哪些场景中使用该GPU。

NVIDIA H200

NVIDIA H200是一款功能极其强大的GPU。在发布时,它是市场上最强大的消费级GPU,如今依然是人工智能开发领域的巨头。H200具备了使NVIDIA H100比其前身NVIDIA A100更强大的所有升级功能,还有更多。值得注意的是,H200采用了略微更新和增强的Hopper微架构,几乎使HBM3E的内存容量翻倍,并提供了比H100高出1.4倍的内存带宽。

让我们更仔细地来看看H200的特点。

NVIDIA H200的特点

- HBM3E 内存 技术:由美光开发,这是目前云上可用的最高带宽内存,使NVIDIA H200能够实现每秒4.8太字节(TB/s)的内存带宽。

- 141 千兆 字节的 内存 容量:提供接近NVIDIA H100两倍的内存容量,这款GPU的强大内存支持最大的深度学习模型在单机或分布式设置上进行训练或推理。

- 第四代 张量 核心与Transformer引擎:H200采用了与H100相同的第四代张量核心技术。这由Transformer引擎实现,该引擎是一个用于在NVIDIA GPU上加速Transformer模型的库,包括在Hopper、Ada和Blackwell GPU上使用8位浮点(FP8)精度,以在训练和推理中提供更好的性能并降低内存使用。

- 第二代安全多实例 GPU ( MIG ) :H200可以在虚拟环境中分为七个安全且并发的GPU实例,支持多租户、多用户的配置,每个实例拥有16.5千兆字节的内存。

- 第四代 NVLink:第四代NVLink有效扩展了多实例GPU的IO交互,每秒可实现高达900千兆字节(GB/s)的双向带宽,据估计是PCIe Gen5带宽的7倍以上。

- 第三代NVSwitch:第三代NVIDIA NVSwitch支持可扩展的层次化聚合和规约协议(SHARP)的网络内计算,并在八个H100(或H200)GPU服务器中提供了相比上一代A100张量核心GPU系统两倍的all-reduce吞吐量提升。

所有这些特点共同构成了目前最强大的人工智能开发工具之一。

NVIDIA H200 Vs. NVIDIA H100

只要一提到NVIDIA H200,它就经常会被拿来与NVIDIA H100进行比较。

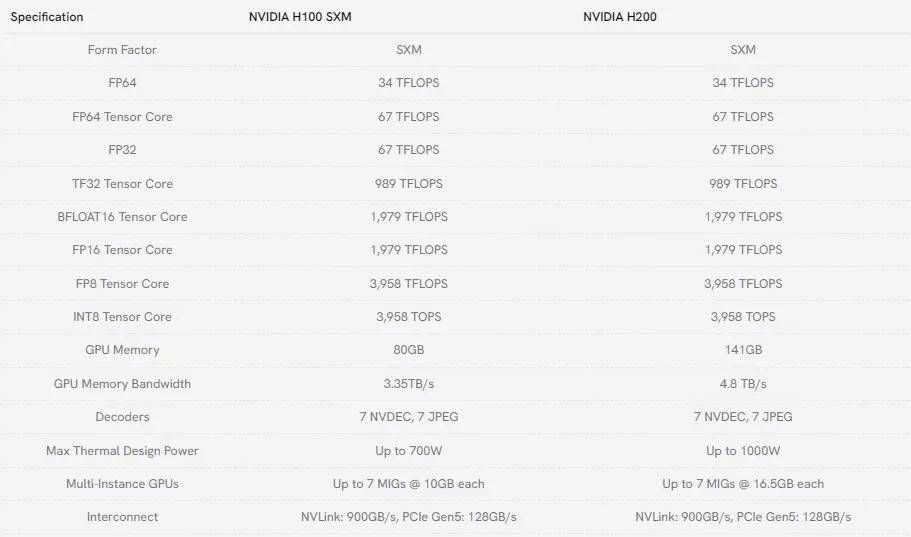

从上表可以看出,这两款GPU同属Hopper微架构代的机器,在功能上有很大的重叠。考虑到构成NVIDIA H100和H200的核心技术相同,这也算情理之中。

H200 与 H100的关键区别在于我们之前提到的GPU内存和GPU内存带宽。其他显著差异包括它们的最大热设计功率和多实例GPU的大小:H200在处理更高瓦数和更好地散热方面优于H100,并且它可以承载更多的MIG(多实例)。

何时使用NVIDIA H200

鉴于其在内存容量和吞吐量方面的优势,NVIDIA H200是一款比H100更强大的机器。因此,这些机器在云上的定价将反映这一点。因此,我们需要考虑在何时何地使用NVIDIA H200。

首先,在效率方面,NVIDIA H200应该始终是首选。仅吞吐量的巨大提升就能确保你的人工智能训练或推理在性能速度上显著优于NVIDIA H100。Hopper微架构的其他改进也有助于加速GPU进程,特别是大型语言模型(LLMs)。

其次,始终要考虑成本。NVIDIA H200比NVIDIA H100更强大,因此在云上运行和访问的成本也相应更高。当成本是考虑因素时,我们需要考虑较小的NVIDIA H100是否能够胜任任务。如果可以,那么使用NVIDIA H100可能更为划算。

如果NVIDIA H100的内存太小,无法处理任务,例如尝试托管一个最先进的LLM,那么NVIDIA H200可能是更优的选择。这引出了第三个考虑因素,即计算成本。我们必须始终考虑GPU是否能够在其硬件限制内处理我们交给它的任务。由于NVIDIA H200拥有显著更大的内存(141 GB对比H100的80 GB),因此在处理最大模型时,它始终是更好的选择。例如,8个H100的设置无法完美运行DeepSeek-R1,而8个H200的配置则可以。

总之,这三点考虑为我们提供了一个框架,以选择适用于我们使用场景的最佳GPU。尽管这两款机器都有各自的优缺点,但我们几乎总是推荐NVIDIA H200用于人工智能推理和训练任务,因为其更高的性能能力。除非成本是最重要的考虑因素,在这种情况下,H100可能是一个合适的替代品。

结语

NVIDIA H200是一款功能极其强大的GPU,适用于人工智能训练和推理,是对NVIDIA H100的显著升级。我们建议将其用于所有与深度学习相关的任务,显然它已经在持续的人工智能革命中发挥着重要作用。

目前,在市面上有部分云服务平台已经开始提供 H200 GPU 服务器,而其中,DigitalOcean 的 H200 GPU 裸机服务器属于性价比最好的一款。用户不仅可以获得服务器的全部硬件资源,保证数据安全,更能获得相较其它云服务更加透明且实惠的价格。当然,DigitalOcean 同样提供包括 H100、A100、L40s 等型号 GPU 服务器。如果你对其中任何一款 GPU 服务器感兴趣,可以直接联系我们。